Hintergründe zu der Google Warnung

Bereits in 2012 hat Matt Cutts Webseitenbetreiber angehalten, keine CSS/JS Dateien via robots.txt zu blockieren, da Google Websites in Gänze crawlen und verstehen möchte.

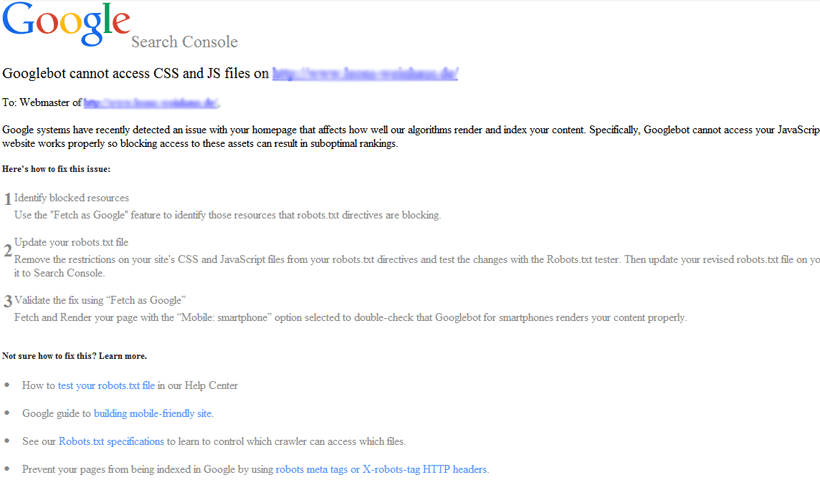

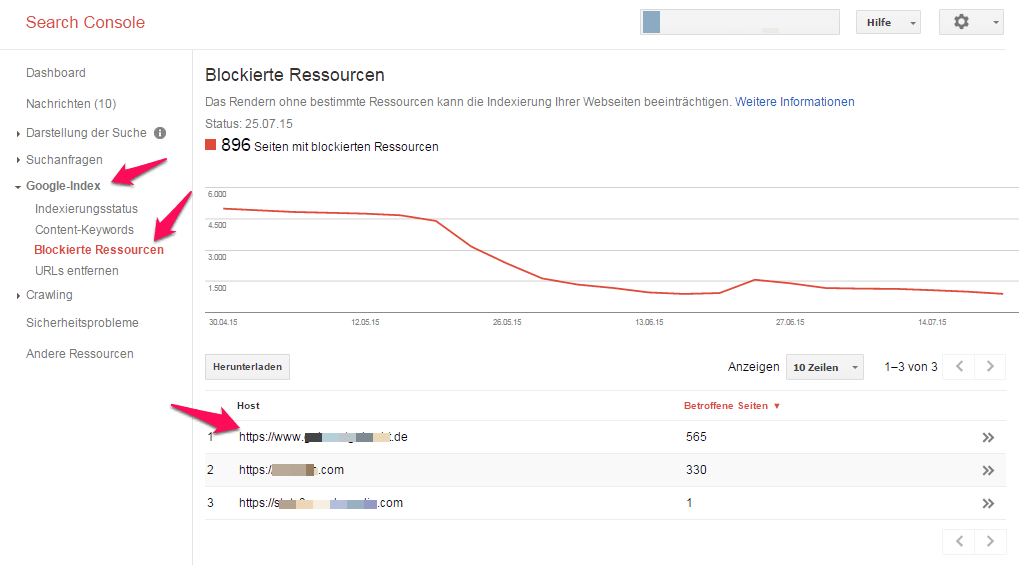

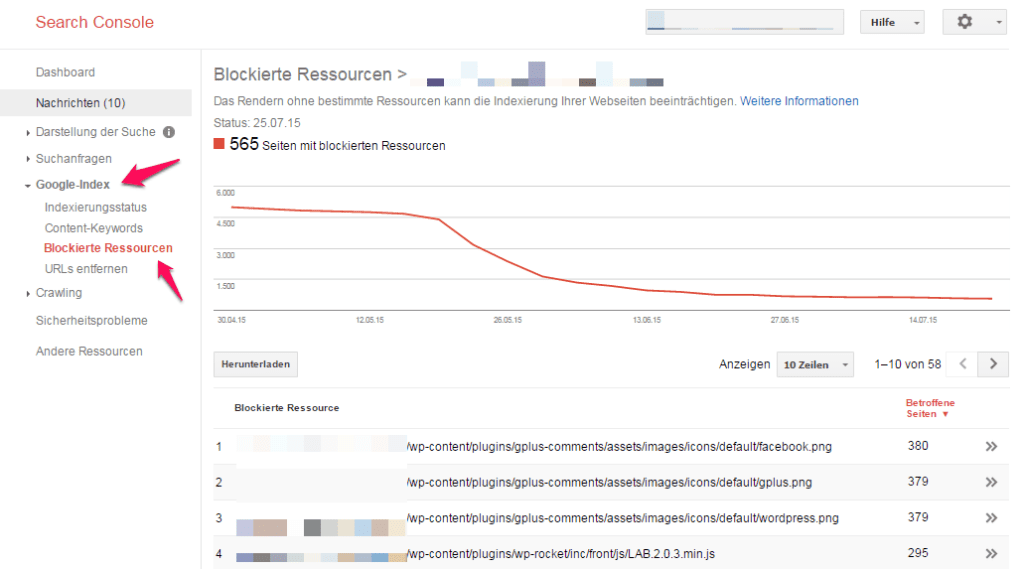

Im Mai 2014 wurde das Google Search Console (ehemals Webmaster-Tools) Feature „Abrufen durch Googlebot“ um „Abrufen und Rendern“ erweitert. Durch diese Erweiterung konnten nicht nur neue Seiten „schneller“ an den Index geschickt werden, sondern auch Fehler beim Rendering (beispielsweise durch blockiertes JavaScript oder CSS) visualisiert werden. Eine entsprechende Änderung der Webmaster Guidelines JS/CSS Dateien nicht zu blockieren, folgte im Oktober 2014.

Damit Google die Inhalte Ihrer Website vollständig interpretieren kann, lassen Sie zu, dass alle Assets Ihrer Website, wie CSS- und JavaScript-Dateien, gecrawlt werden. Durch das Indexierungssystem von Google werden Webseiten unter Verwendung des HTML-Codes einer Seite sowie mithilfe der entsprechenden Assets wie beispielsweise Bilder, CSS und JavaScript-Dateien gerendert.